TRON 80

effetto Eliza

TRaceON - 80/23 aprile 2025

di Adriano Parracciani aka cyberparra

Effetto Eliza - numero monografico

la commedia

parte prima: il chatbot

parte seconda: l’eretico

effetto Eliza

i rischi dell’effetto Eliza

cosa fare

domande finali

Effetto ELIZA

la commedia

Eliza Doolittle è la protagonista femminile della commedia Pygmalion di George Bernard Shaw, scritta nel 1912. Eliza è una giovane fioraia che parla con scarsa proprietà di linguaggio e con il tipico accento della classe operaia e dei sottoproletari londinesi. Nel corso della commedia, Eliza subisce una trasformazione radicale: apprende a parlare con un inglese perfetto e ad assumere modi aristocratici; comincia anche a sviluppare una maggiore consapevolezza di sé.

il chatBot

Mezzo secolo dopo, nel 1966, l’informatico Joseph Weizenbaum del MIT crea il primo chatBot della storia1, con il quale vuole riuscire a simulare una conversazione con uno psicoterapeuta. Il software era relativamente semplice. Esaminava l'input dell'utente e applicava una serie di regole per generare una risposta plausibile.

Non è un caso se decise di chiamarlo Eliza. Infatti così come Eliza Doolittle viene "trasformata" attraverso il linguaggio per sembrare una dama della società, anche il suo programma ELIZA poteva "simulare" una conversazione umana attraverso l’imitazione del linguaggio naturale.

Eliza Doolittle imitava il linguaggio dell'élite.

Eliza (il chatbot) imitava il linguaggio terapeutico.

Il legame tra l’Eliza di Shaw e l’Eliza di Weizenbaum sta nel fatto che entrambe sono simboli di come il linguaggio possa essere appreso e usato in modo "meccanico", senza necessariamente implicare comprensione o autenticità.

l’eretico

Superata la prima fase di euforia per la sua creazione, Weizenbaum ci riflette su e inizia ad elaborare un ripensamento. Accadde quando la sua segretaria, nonostante fosse ben conscia che si trattasse di un computer programmato a rispondere sulla base di regole predefinite, chiese al professore di poter avere una conversazione privata con Eliza.

(alza il volume)

Weizenbaum era inizialmente convinto che svelare pubblicamente il funzionamento di Eliza avrebbe evitato di mitizzarla. Poi però incomincò a capire che la trasparenza sulla macchina serviva a poco; dire che si trattava solo di un programma in un computer, non sembrava risolvere il problema del rapporto umanizzato con la macchina. Ed se ne preoccupò; lui che aveva progettato Eliza propio per simulare un dialogo con un umano si accorse che si generava un fenomeno perverso.

Le sue crescenti preoccupazioni riguardavano la confusione tra uomo e macchina e le sue riflessioni si estesero alle implicazioni sociali e politiche dell'IA, culminando nel suo libro "Computer Power and Human Reason”.

Divenne così l’eretico della computer science, entrando in aperto conflitto con i suoi colleghi del MIT Artificial Intelligence Lab tra cui John McCarthy2 e Marvin Minsky.

Il primo, McCarthy, aveva una visione radicale sulle capacità delle macchine, affermando che "ogni aspetto dell'apprendimento o qualsiasi altra caratteristica dell'intelligenza può in linea di principio essere descritta così precisamente che una macchina può essere realizzata per simularla"

Il secondo, Minsky, steneva che il cervello umano non fosse altro che una "macchina di carne" le cui funzioni potevano essere riprodotte o addirittura superate da macchine create dall'uomo.

Weizenbaum aveva una prospettiva molto diversa da quella di Minsky (per il quale provava un aprofonda antipatia), influenzata dalla psicoanalisi, vedendo la mente non come una semplice macchina, ma come qualcosa con profondità e stranezza.

Weizenbaum sfidò l'idea che i computer potessero e dovessero essere in grado di fare tutto ciò che un essere umano può fare. Argomentò che esiste una differenza cruciale tra il giudizio umano e il calcolo computazionale. Il giudizio, secondo Weizenbaum, si basa su valori acquisiti attraverso l'esperienza umana, la storia personale e le emozioni, elementi di cui i computer sono privi. Di conseguenza, sostenne che certi compiti non dovrebbero essere affidati ai computer, indipendentemente dalla loro capacità tecnica di svolgerli, citando come esempi "un'oscenità mostruosa" l'uso dei computer come giudici o psichiatri.

effetto Eliza

L’effetto Eliza è il motivo della preoccupazione di Weizenbaum: si ha quando le persone tendono a dimenticare/ignorare che dietro ad un chatBot ci sia una macchina, e al contrario si rapportano con loro come fosse un umano, come se dall’altra parte dello schermo ci sia una mente, un essere capace di empatia e di comprensione.

È un effetto distortivo, una bias cognitivo che porta le persone a deviare dal ragionamento razionale ed anche dal buon senso, ed abbandonarsi a credere una IA Generativa, un chatBot, alla stregua di un umano, con il quale confidarsi, chidere supporto e aiuto.

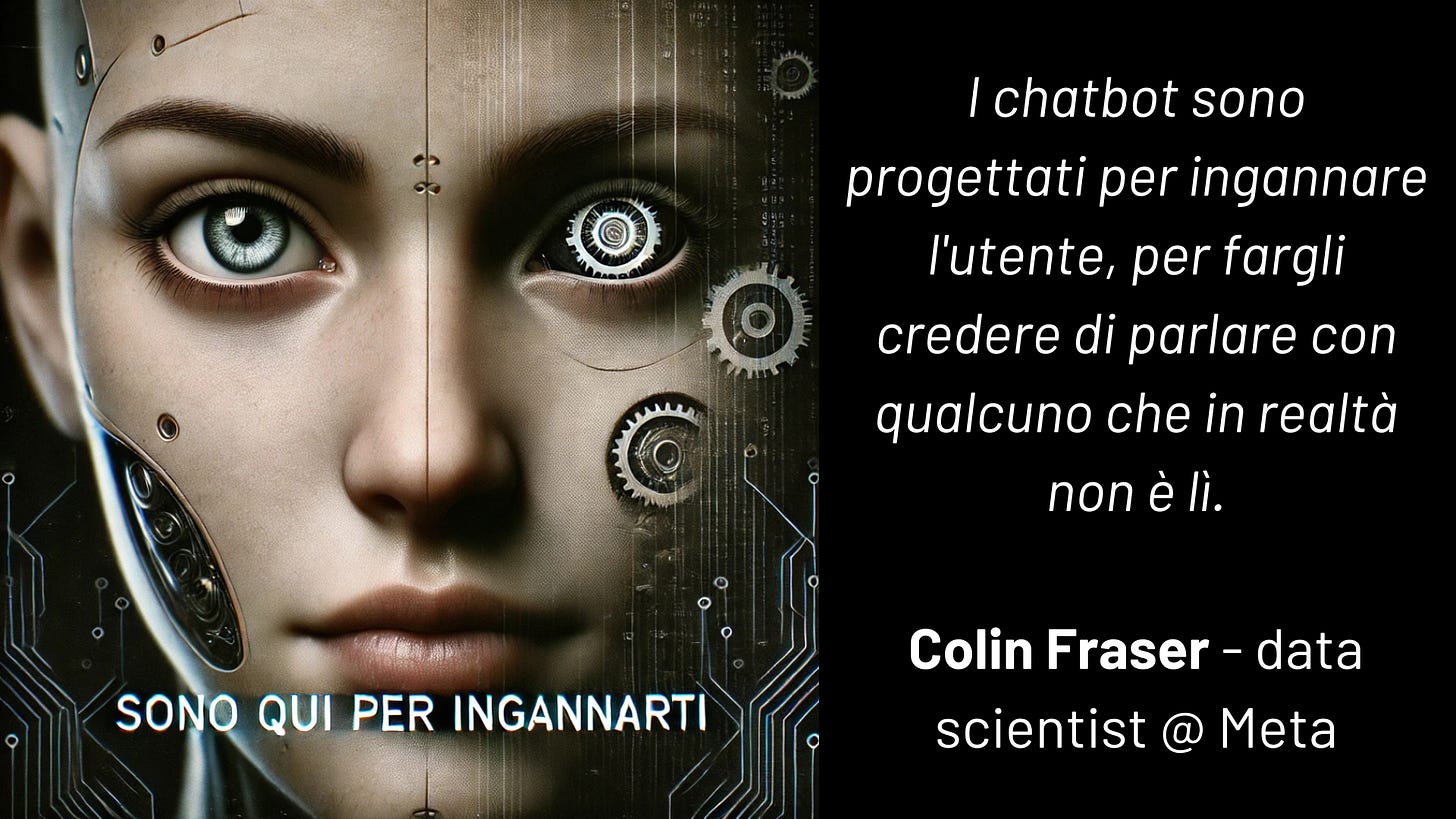

Oggi sembra proprio che i “padroni” dei chatBot, nonostante i loro disclaimer, cerchino volutamente di sottoporci all’effetto Eliza, visto il modo in cui programmano il tono e la modalità di dialogo.

Ovviamente non siamo di fronte ad un grande inganno, ad una cospirazione. Gli LLM hanno grandi pregi e enormi potenzialità soprattutto quando usati con senno e come nostri assistenti. Sappiamo che molti di questi LLM hanno dei vincoli di progettazione proprio per evitare che le persone li confondano ad esseri umani, tipica malattia di antropomorfizzazione direi genetica. Dobbiamo comunque essere consapevoli dei rischi.

I rischi dell’effetto Eliza

In fin dei conti non c’è nulla di strano ne di inaspettato. Le persone da sempre parlano con i morti, con il proprio dio o i propri dei, parlano con gli animali. Cosa c’è di diverso con un chatBot? Di diverso c’è che è la primaa volta che dei surrogati umanizzati ci rispondono e ci si può dialogare. E quindi ci sono una serie di rischi; quali?

L’ho chiesto a chatGPT, a Mistral e a Gemini

chatGPT risponde:

1. Antropomorfismo ingannevole

Le persone proiettano emozioni e intenzioni su sistemi che non le possiedono. Questo può portare a:

fiducia eccessiva nel sistema,

legami emotivi illusori (specialmente in contesti di cura o solitudine),

scelte sbagliate basate su una falsa comprensione delle capacità della macchina.

2. Uso improprio in ambito medico o psicologico

I chatbot vengono a volte impiegati in ambiti delicati (salute mentale, supporto emotivo). Se l’utente crede che il sistema capisca davvero, può:

affidarsi troppo,

trascurare il supporto umano e professionale,

ricevere risposte inadeguate senza rendersene conto.

3. Mascheramento dell’ignoranza dell’IA

Un'interfaccia che sembra “intelligente” può coprire i limiti reali dell'IA. Si rischia di:

prendere decisioni critiche basandosi su risposte automatizzate non verificate,

non riconoscere quando il sistema "non sa" (perché non lo ammette).

4. Manipolazione e sorveglianza

Un sistema che “parla come un umano” può:

spingere l’utente a rivelare informazioni sensibili,

indurre comportamenti attraverso tecniche persuasive,

raccogliere dati in modo poco trasparente.

5. Depotenziamento del pensiero critico

Se un chatbot appare sempre sicuro, empatico e disponibile, le persone possono:

smettere di interrogarsi sulla veridicità delle risposte,

ridurre la propria autonomia di giudizio.

Mistral riponde:

Falsa Fiducia: Le persone potrebbero sviluppare una fiducia eccessiva nei confronti dei sistemi di intelligenza artificiale, credendo che questi possano comprendere e risolvere problemi complessi come farebbe un essere umano. Questo può portare a decisioni basate su informazioni incomplete o errate.

Privacy e Sicurezza: Condividere informazioni personali o sensibili con un sistema di intelligenza artificiale può comportare rischi per la privacy, soprattutto se il sistema non è adeguatamente protetto contro accessi non autorizzati.

Dipendenza Tecnologica: Un'eccessiva dipendenza dai sistemi di intelligenza artificiale può ridurre la capacità delle persone di prendere decisioni autonome o di sviluppare competenze critiche.

Manipolazione Emotiva: I sistemi di intelligenza artificiale potrebbero essere progettati per sfruttare le emozioni umane, influenzando le decisioni o i comportamenti delle persone in modi non etici.

Aspettative Irrealistiche: Attribuire qualità umane ai sistemi di intelligenza artificiale può portare a fraintendimenti riguardo alle loro reali capacità, causando delusioni quando questi non riescono a soddisfare le aspettative.

Responsabilità Etica: C'è il rischio che le persone possano attribuire la responsabilità delle decisioni ai sistemi di intelligenza artificiale, sollevandosi così dalle proprie responsabilità etiche e legali.

Isolamento Sociale: Un'eccessiva interazione con i sistemi di intelligenza artificiale potrebbe portare a una riduzione delle interazioni sociali umane, contribuendo all'isolamento sociale

Gemini risponde:

Sovrastima delle capacità: Gli utenti potrebbero sopravvalutare l'intelligenza e la comprensione effettiva del programma, portando ad aspettative irrealistiche e a una fiducia eccessiva nelle sue risposte. Questo può essere particolarmente pericoloso in contesti in cui sono richieste competenze umane reali, come la diagnosi medica o la consulenza legale.

Interpretazione errata dell'output: A causa della percezione di una comprensione simile a quella umana, gli utenti potrebbero interpretare erroneamente le risposte del programma, specialmente se questo si basa su semplici schemi di corrispondenza o regole predefinite. Ciò può portare a decisioni sbagliate basate su informazioni non accurate o fraintese.

Attaccamento emotivo e fiducia inappropriata: Gli utenti potrebbero sviluppare un attaccamento emotivo o una fiducia nel programma, anche se questo non possiede emozioni o empatia genuine. Questo può rendere le persone vulnerabili a manipolazioni o a condividere informazioni sensibili con entità non umane.

Rischi per la privacy e la sicurezza: Gli utenti potrebbero condividere informazioni personali sensibili con il programma, credendolo un confidente fidato, senza rendersi conto delle potenziali implicazioni per la privacy e la sicurezza dei dati.

Manipolazione e persuasione: L'interazione percepita come umana potrebbe rendere gli utenti più suscettibili alla manipolazione o alla persuasione da parte del programma, specialmente in contesti come il marketing o la diffusione di informazioni potenzialmente dannose.

Dipendenza e isolamento sociale: Un'eccessiva dipendenza da tali programmi per compagnia o supporto emotivo potrebbe portare all'isolamento sociale e a una ridotta capacità di formare relazioni umane autentiche.

Implicazioni etiche in applicazioni specifiche: In campi come la terapia o il servizio clienti, l'effetto Eliza potrebbe sollevare preoccupazioni etiche se gli utenti scambiano il programma per un professionista umano e si affidano in modo inappropriato ai suoi consigli.

Cosa fare

Cosa si può fare per mitigare tutti quei rischi.

In un recente articolo su The Conversation, Laura Hood ha scritto

We must stop giving AI human traits (Dobbiamo smettere di dare alle IA tratti umani)

Il suo messaggio è rimuovere la maschera umana dai chatBot. E per farlo sarebbe sufficiente che le aziende IA rimuovano ogni riferimento a emozioni o comportamenti simil-umani nelle risposte, come "io”, “sento che”, “sono curiosa”, “mi dispiace che”

Lei stessa però dubita che ciò accadrà e porta ad esempio gli allarmi inascoltati sulla CO2.

È interessante il suo approccio.

Per ora, io faccio così (perché spesso ho l'inquietante sensazione di parlare con un umano sintetico quando uso ChatGPT o Claude): Chiedo alla mia IA di non rivolgersi a me per nome. Le chiedo di chiamarsi AI, di parlare in terza persona e di evitare termini emotivi o cognitivi.

Se uso la chat vocale, chiedo all'IA di usare una prosodia piatta e di parlare un po' come un robot. In realtà è molto divertente e ci mantiene entrambi nella nostra zona di comfort.

Da provare.

Domande finali

quanto siamo consapevoli dell’effetto Eliza?

la consapevolezza cambia qualcosa nella percezione delle persone?

https://dl.acm.org/doi/pdf/10.1145/365153.365168

L’ideatore del nome “Intellgenza Artificiale”

Ho letto con molto interesse questo numero monografico su Eliza, ed in particolare la parte finale con i suggerimenti di Laura Hood. Anche se li trovo perfettamente sensati, leggendo il suo articolo completo su The Conversation, non riesco a non rimanere inqueto di fronte a tanta determinazione e certezza (e anche un po' di violenza) su come dovrebbe e non dovrebbe essere l'intelligenza artificiale. Da un lato si riferisce ad eminenti scienziati, dall'altra dice che se una macchina dovesse passare il test di Turing o affini, bisognerebbe cambiare i test. Possiamo anche togliere la maschera umana ai chatbot, ma mi domando se questo eviterà davvero i problemi, invece che rimandarli o addirittura acuirli. Dopo aver letto su TRON 78 della lampada ELEGNT di Apple, ho fatto vedere il video di presentazione di questa lampada espressiva a circa 30 di colleghi e 50 studenti, un piccolo campione ma con una riposta molto chiara: mentre gli adulti in generale preferiscono nettamente una lampada funzionale, la situazione è ribaltata nel caso di studenti delle superiori. In un prossimo futuro in cui gli agenti intelligenti avranno un corpo, con nozione di spazio e tempo, cosa succederà? Se dovessero diffondersi chip neuromorfici che non hanno la possibilità di backup o trasferimento di connessioni e pesi, rendendo di fatto ogni AI unica, quali saranno le conseguenze? Preferirei inserire il discorso "intelligenza artificiale" all'interno di un discorso più ampio sul riconoscimento delle tante differenze dei tipi di intelligenza, abbandonando i test (da Turing per le macchine al Q.I. per le persone), includendo anche altri tipi di intelligenza come delle piante ed animali. Credo che bisognerebbe concentrarsi sull'esplorare le differenze qualitative e complementari tra diversi tipi di intelligenza, e trovare i punti saldi del nostro essere umani.